Het Internet is groot. Het bestaat uit miljarden websites, die elk een aantal pagina’s bevatten. Het navigeren in deze digitale jungle is dan ook een complexe taak. We begrijpen allemaal hoe nuttig zoekmachines zijn in het filteren van deze chaos. En de meesten onder ons begrijpen ook dat websites niet toevalligerwijs in de top van de zoekresultaten terecht komen. Of waarom specifieke advertenties aan de bovenkant van de pagina staan. Maar begrijpen we werkelijk hoe dit alles werkt?

Zoekmachines worden gebruikt om te vinden, te indexeren en om informatie van het internet op te halen. Deze werkwijze volgt een aantal stappen:

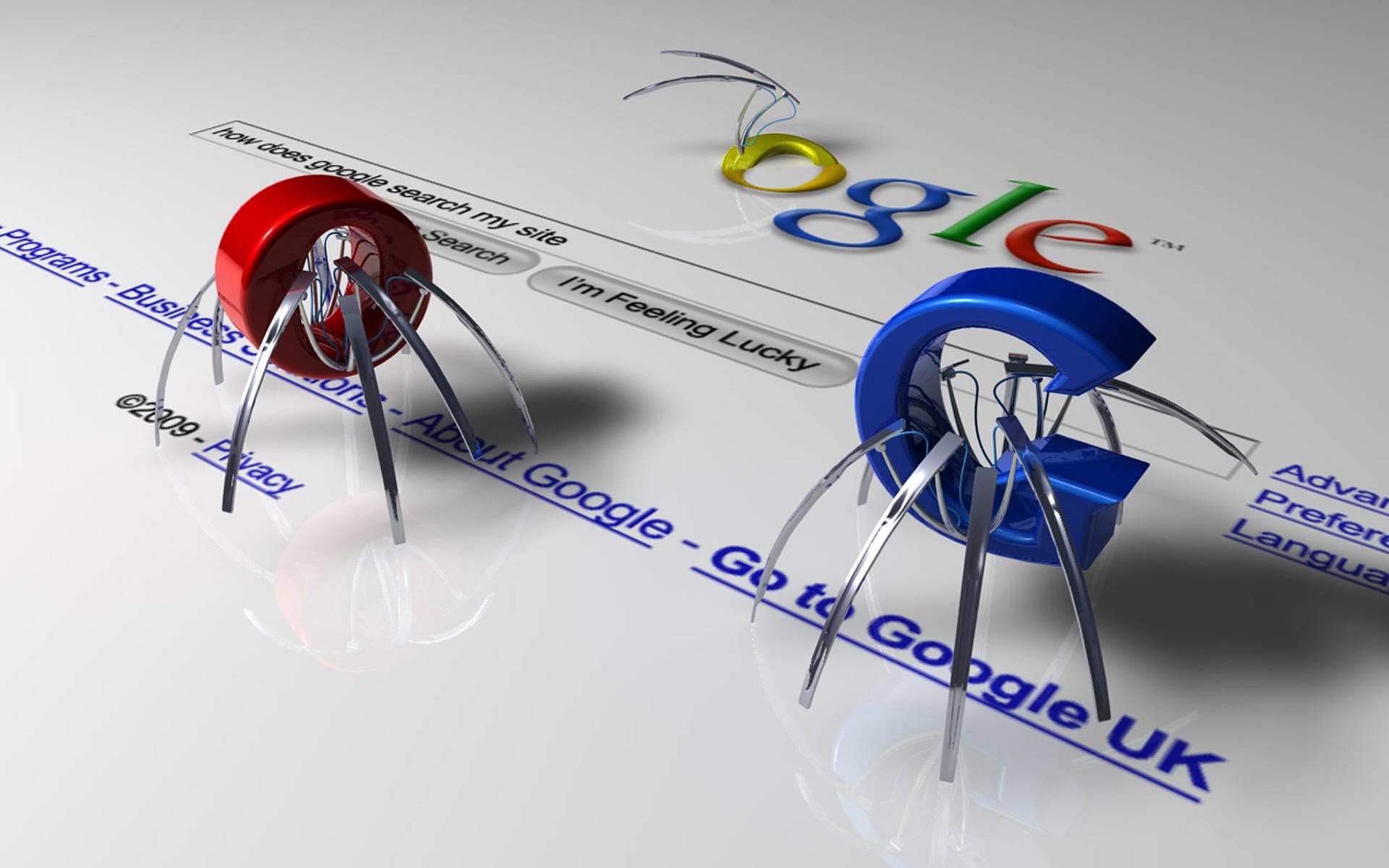

Crawling

Wanneer een zoekterm in een zoekmachine is ingevoerd, maakt de zoekmachine gebruik van zogenoemde ‘spiders’ of ‘bots’ die websites pagina voor pagina scannen op bruikbare inhoud. Dit wordt in het Engels ‘crawling’ genoemd. In wezen bekijken deze ‘spiders’ of ‘bots’ elke pagina net zoals een mens dat zou doen, alleen verloopt dit proces supersnel. Op het moment dat een pagina op die manier wordt bezocht, wordt informatie verzameld die betrekking heeft op uw zoekopdracht. Elke keer dat een crawler een webpagina bezoekt, maakt het er een kopie van en wordt de URL aan de zoekindex toegevoegd. Bij dit indexeringsproces draait het niet alleen om de platte tekst op een pagina. Ook alle links die er te vinden zijn worden gescand en gevolgd. Hierdoor ontstaat een index van deze webpagina . Er wordt daarbij tevens gekeken naar specifieke items, zoals paginatitels, afbeeldingen, de inhoud, trefwoorden en welke links naar bepaalde pagina’s gemaakt zijn. Op die manier kan het zoeksysteem een goede indruk krijgen van de wezenlijke inhoud van een pagina.

Indexering

Nu de pagina eenmaal bezocht is, kan deze worden geïndexeerd of in relevantie met anderen worden gebracht. De volgorde wordt bepaald door een algoritme genaamd PageRank. Simpel gezegd, PageRank is een complex algoritme, dat de verschillende kwaliteiten van een bepaalde webpagina beoordeelt. Links naar een webpagina van andere websites kunnen bijvoorbeeld de ranking van een pagina vergroten; hoe meer relevante links naar een webpagina verwijzen, des te relevanter meent PageRank dat deze pagina is en des te hoger deze vervolgens in de zoekresultaten gerangschikt wordt. Dat is echter niet zo eenvoudig als het klinkt.

Het bepalen van relevantie

In de vroege dagen, maakten zoekmachines gewoon een match met de zoekwoorden in de zoekterm en de zoekwoorden op een webpagina. Het keek ook naar het aantal links wat naar uw website verwees en bepaalde op basis daarvan dat websites met meer links als populairder beschouwd konden worden en daarom dus een hogere rangschikking verdienden. Echter, na verloop van tijd werd duidelijk dat men moest gaan evolueren. Steeds meer mensen begonnen namelijk hun webpagina’s vol te proppen met trefwoorden of ze creëerden veel irrelevante links om de zoekmachines voor de gek te houden en zodoende de top van de zoekresultaten te kunnen bereiken. Vandaag de dag beïnvloeden honderden factoren de relevantie van een website. Dit zijn de zogenaamde ‘Ranking Signals’. Deze signalen en kunnen variëren van de mobiel-vriendelijkheid van uw website tot aan sociale signalen vanaf platformen als Facebook, Twitter en Google+ naar de te indexeren content.

Google Penguin & Panda

Google domineert op het vlak van zoekmarketing. Ongeveer 70% van het zoekverkeer verloopt via deze gigant. Bing staat op de tweede plaats en neemt 17% voor haar rekening, terwijl Yahoo de top 3 compleet maakt met 13%. In 2011 lanceerde Google Panda om daarmee sites die content van lage kwaliteit bevatten uit de hooggeplaatste posities van de zoekresultaten te kunnen weren. Als gevolg hiervan daalden pagina’s die een kwalitatief slechte inhoud en veel reclame bevatten significant in de rangschikking. Sites van hoge kwaliteit kregen daarentegen een betere kans op het bereiken van hoge posities.

In 2012 introduceerde Google tevens Penguin om het onkruid van de SERPs te kunnen verdelgen. Men was namelijk van mening dat deze methode te vergelijken was met het spammen van resultaten. De hoge rangschikkingen werden met deze methode bijvoorbeeld behaald door links van anderen te kopen of door een website te koppelen aan een netwerk wat specifiek opgetuigd was voor voor het behalen van hoge rangschikkingen. Al deze methoden vormen een inbreuk op Google’s richtlijnen voor webmasters. Penguin betekende dat de rangschikking van sites verlaagd werd, wanneer deze zich bezig hielden met het beoefenen van zogenoemde ‘black-hat’ SEO-technieken, waaronder het plaatsen van dubbele content, het overmatig optimaliseren van teksten middels sleutelwoorden (keyword stuffing) en pogingen om de spiders van de zoekmachine om de tuin te leiden middels cloaking.

SEO-experts zijn dankzij Panda en Penguin veel transparanter geworden in hun manier van optimalisering. Met “black hat” technieken kunnen slechts kortstondig resultaten worden bereikt. Op de lange termijn hebben ze echter een zeer nadelig effect op de rangschikking van een website.

We hopen dat de wereld van zoekmachines dankzij dit artikel een beetje duidelijker geworden is. Als u echter meer wilt weten over specifieke aspecten van SEO, neem dan gerust contact op met het team van Intelligent Online. We praten u graag bij.

Dit artikel is ook gepost op Marketing Med

Bron: SocialB